2. 清华大学地球系统科学研究中心,北京 100084

2. Center for Earth System Science, Tsinghua University, Beijing 100084

气象高性能计算应用主要是指在高性能计算环境运行的气象数值模式将初边值资料读入特定的数据结构,并对其按照业务逻辑进行高效计算处理,输出标准格式数据产品的工作。它具有系统架构复杂,时效要求高,专业性强等特征,同时具有明显的周期性计算高峰,属于大规模紧耦合密集型计算,在目前及可预见的未来,其实现和运行必须依托于高性能计算服务环境。又因为气象数值模式在现代气象业务中的关键性作用、其发展速度的日新月异及其与气象高性能计算应用的密切关系,因此现代气象业务对高性能计算应用服务环境的需求也具有现代化、多样化、更新速度快的特点,所需的资源包括高性能计算(王彬等,2011),存储及高速互联网络等硬件资源与系统管理、数据应用(沈文海等,2004),以及程序开发等软件资源。

高性能计算应用服务环境的设计和发展需要与高性能计算机基础设施架构紧密结合,从信息技术角度深入解读气象数值模式业务需求,将其作为服务环境建设的引领,从硬件能力和软件实力两方面着手,建设适用于气象行业应用的信息系统(中国气象局,2012)。

欧洲和美国等一些发达国家气象部门在不断扩充和建设高性能计算系统硬件能力的同时,持续发展了相对成熟和稳定的数值模式软件服务环境。如地球系统模式框架ESMF(Earth System Modeling Framework)、用于气候系统建模与模拟的PRISM(Program For Integrated Earth System Modeling),以及面向天气研究和预报的模式系统WRF(Weather Research Forecast)。采用软件工程技术,对领域内各类应用的共同特征进行抽象,形成公共软件基础架构,增强模式系统的可构造性和易用性。

近年来,我国气象数值模式业务领域不断拓宽,对气象高性能计算的服务需求也大幅提升。但是,目前气象高性能计算服务手段和能力相对薄弱,在一定程度上制约了气象数值模式业务的发展(沈文海,2012)。在此背景下,中国气象局依托“气候变化应对决策支撑系统工程”开展了高性能计算系统的建设工作,在进一步加强高性能计算能力建设的同时,也积极开展了气象高性能计算应用服务环境的设计与实施。

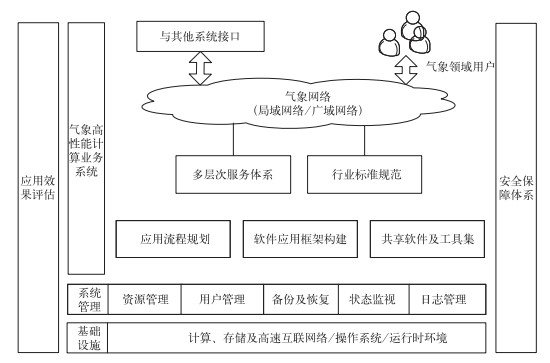

1 系统架构及解决方案 1.1 整体架构气象高性能计算应用服务环境整体架构如图 1所示。引入面向服务体系结构(SOA)的设计理念,实现资源集约配置(杨学胜等,2005),提供统一的面向用户需求的松耦合服务,有利于规范应用结构和流程,提高业务时效,充分发挥信息系统基础设施作用。

|

图 1 气象高性能计算应用服务环境架构 Fig. 1 Architecture of meteorological high performance computing application service environment |

将气象高性能计算应用服务环境建设与实际应用情况相结合进行分析,首先可以通过基础设施的规划调整,满足应用在各阶段对系统资源的需求。在此基础之上,根据模式计算结构设计发展及信息系统架构的发展,选择主要研究方向建立支撑模式研发的应用框架,并提供丰富的软件及工具集。

1.2.1 系统与应用流程统一规划 1.2.1.1 优化模式前/后处理基础设施从工作流的角度划分(胡江凯等,2005),气象高性能计算应用可分为前处理,模式主体运行和后处理3个阶段。其中,前处理阶段的任务是将多类源数据(李湘,2010;李志鹏等,2012)按照规律的时空分布加载入内存,进行相关检索、插值和计算,形成一个与模式相协调的初始状态,作为模式积分的初条件。后处理阶段是对模式模拟数据按照业务需求完成定制提取、格式转换、检验评估(王雨等,2007;温华洋等,2013)等工作。两者均需进行大量数据处理,需要较高的浮点计算能力和访存能力。

随着气象数值模式业务领域的不断拓展,越来越多的前/后处理任务需要在规律性的计算高峰期执行,形成强烈的资源竞争。致使部分业务的前/后处理作业运行在高性能计算系统之外的服务器系统,这些服务器分散于各个业务部门,与高性能计算系统通过局域网络连接。它们缺乏统一的维护管理,系统稳定性和应用可靠性得不到保障,部分服务器硬件资源老化、软件功能落后,应用程序运行效率较低,业务时效性难以得到保障(梁海河等,2011)。

为缓解此类现象,提高模式前/后处理效率,集约优化使用IT资源(王彬等,2010),在高性能计算系统规划专用于此类应用的前/后处理集群,将在一定程度有效提高应用整体效率。

1.2.1.2 设计全局共享及高可用存储集群存储资源是高性能计算系统的核心组成部分,是实现数据集约共享的硬件基础,是计算系统是否可用的关键,同时,其共享程度决定了计算系统资源调配的灵活性和负载的均衡性。

1.2.1.3 应用流程规划目前,主要气象数值模式应用流程均按照不同的业务系统纵向条带化开发和管理。每个业务系统都包含各自独立的数据收集加工、主模式运行、模式结果后处理、产品分发、数据归档等功能模块。

从业务系统整体考虑,对各业务流程模块按照应用功能、数据接口、计算类型进行梳理、分析、分解和重组。确定各模块之间的业务逻辑关系,所需运行环境及数据,作业运行等信息。寻求各独立业务系统之间的共性,将具有共性的功能模块整合、规范、共享(赵立成等,2002),实现应用功能的模块化、扁平化、集约化实施和管理(吴林林等,2013;郑永光等,2013;高嵩等,2014;嵇磊等,2014)。

1.2.2 模式软件应用框架构建气象数值模式的理论建模、数值求解以及软件实现是一个典型和复杂的高性能计算问题(王斌等,2008),相关并行算法与软件实现技术仍是薄弱环节,在一定程度上制约了模式的发展。而模式分辨率的提高,各种物理过程的增加或完善,使得在每一个积分时间步中,浮点计算次数大量增加,对浮点计算能力和I/O能力有很高的需求,另一方面,在模式计算过程中,涉及到按一定频率进行全局/局部数据的分发和收集,对数据交换能力具有很高的需求(薛纪善等,2008)。以政府间气候变化专门委员会第五次评估报告(IPCC AR5) 重大科学试验任务为例,完成所要求的评估试验,整个模式系统需积分7500个模式年以上。完成如此复杂的模拟任务,一方面需要更多计算能力的支撑,另一方面需要提高数值模式自身发展水平。

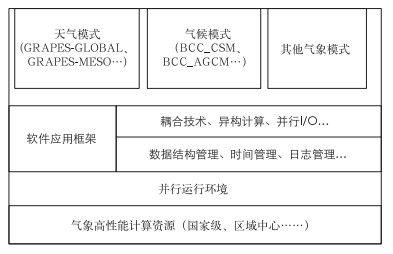

框架是一个能够被软件开发人员实例化的系统骨架,提供一组互相协作的类(或构件)及运行时对象,可用于生成特定领域的应用软件。将框架技术应用到数值模式发展过程中,把模式的开发看作一个组装过程,以框架为基础,确定可复用构件并进行系统组装,实现代码和设计的重用。模式软件应用框架作为高性能计算机系统与数值模式之间的软件层(图 2),对计算系统硬件和软件进行高度抽象,屏蔽底层技术细节,提供支持不同高性能计算体系架构的统一编程接口和分布式协同开发环境,实现不同分量模式之间交互界面的标准化,使模式研发界面透明友好、操作便捷。基于几个主要研究方向,开展模式软件应用框架的构建及优化工作。

|

图 2 气象数值模式软件应用框架 Fig. 2 Software application framework of meteorological numerical model |

自20世纪70年代开始,人们对气候系统的认识逐渐加深,在考虑大气圈的同时,也开始关注其他各圈层(海洋、陆面、生物圈等)内部及其相互之间的非线性作用。在采用数值模拟方法开展科学研究的过程中,各圈层内部的变化可以通过各领域自身的数值模式来实现,各圈层之间的相互作用则需要通过耦合技术来实现(王在志等,2005)。早期的耦合过程主要通过子模块调用的方式完成(魏敏等,2005),随着模式自身和科学技术的不断发展,各分量模式之间交互关系越来越复杂,产生了独立的耦合器负责执行大量的全局通信,完成各分量模式之间的数据插值和交换。

目前,欧美等国家和地区都很重视耦合技术的研究与应用。国际上比较有影响的耦合器主要包括美国国家大气研究中心(NCAR)的通用气候系统模式(CCSM)的CPL、美国地球物理流体动力学实验室(GFDL)的FMS和法国欧洲科学计算研究与高级培训中心(CERFACS)的OASIS。随着模式规模不断扩大,模式结构日益复杂,我们也亟需研究可提供高精度多维插值和高效数据传输等功能的标准化耦合技术,促进我国气象数值模式的发展。

1.2.2.2 异构计算近年来,以GPU、MIC等众核部件进行计算加速的异构高性能计算系统受到越来越多的关注。在一定程度上,使得提高现有计算机体系实际计算效率,更好地满足数值模式需求成为可能。

美国和日本等国家已经开始针对新一代异构高性能计算系统着手改造和优化气象数值模式。随着行业技术的发展,我国异构气象高性能计算系统的建立也成为大势所趋,面对计算系统硬件体系结构的重大变革,开展异构众核编程技术的研究工作也已迫在眉睫。

1.2.2.3 并行I/O技术高效数据并行I/O技术是提高气象数值模式运行效率极其重要的方法,是海量数据访问技术的发展趋势。现阶段,大部分数值模式的计算部分已基本实现多处理器核并发完成,但是数据访问模块仍采用单处理器核串行执行。越来越高的时空分辨率,更复杂、更精细的物理、化学和生物等过程的描述,使模式数据海量聚积,同时计算结果输出频率也越来越高,极大地增加了I/O工作量。传统的单进程数据访问技术已经不能满足业务系统运行时效性需求,进而成为模式运行效率新的瓶颈。

国外模式研发团队已经将并行I/O技术应用到实际模式发展工作中,如NCAR研发的地球系统模式(CESM)采用PIO库为各分量模式提供并行I/O服务,GFDL开发的全球海洋环流模式(MOM)采用一系列函数支持数据并行I/O。无论是在现阶段气象数值模式业务运行和研发工作中,还是在更高分辨率模式发展工作中,提高模式数据访问效率已经成为关键技术之一。

随着对以上技术研究的不断深入,将耦合、异构计算和并行I/O、数据结构管理、时间管理、日志管理等软件算法构件形成模式软件应用框架,为数值模式发展提供集成的优化算法,实现科学计算代码的共享,使模式具有通用的应用软件特性,便于模式系统的推广和发展。

1.2.3 共享软件及工具集数值模拟研究学科交叉性很强,模式开发调试,模拟结果分析等过程涉及到高性能计算、数据统计分析、可视化等不同领域。针对数值模式的计算特点和数据特性,需要为模式研发人员提供一系列常用软件和工具,满足应用需求,提高模式研发效率。

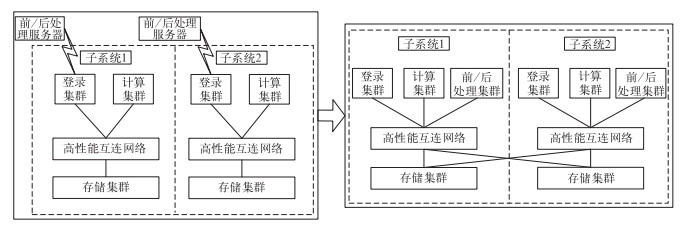

2 服务环境的实施与规划 2.1 系统设计优化(1) 在新建设的高性能计算机系统设计实施了专用的前/后处理集群,峰值计算能力达到约10TFLOPS,单CPU核配置8 GB内存(图 3)。通过这项系统优化工作,将减少数据重复存储,减小网络流量压力,缩短业务运行周期,提高预报产品时效。在未来系统建设工作中,可对UNIX/LINUX共存的异构集群技术进行探索,提高系统对行业应用软件、程序的兼容支撑能力。

|

图 3 气象高性能计算系统设计优化 Fig. 3 Optimization of meteorological high performance computing system design |

(2) 高性能计算系统规划为两个子系统,每个子系统分别包括登录集群、计算集群、前/后处理集群和存储集群,两个子系统的登录集群、计算集群和前/后处理集群相互独立,存储集群交叉共享。在一个子系统同时可以访问两个子系统的存储资源,提高了计算及存储资源的使用效率。另一方面,在一个子系统的计算集群失效时,其存储集群仍可被另外一个子系统访问,保障了存储资源的高可用性。在未来工作中,可结合作业调度管理策略,对重要业务应用进行灵活的实时备份。

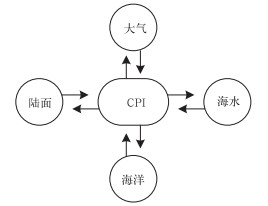

2.2 模式软件应用框架技术研究(1) 国家气候中心的BCC_CSM模式(Wu et al,2013)是典型的气候系统模式,它由大气、陆面、海洋和海冰四个分量模式构成,通过CPL耦合器实现各分量模式之间的双向动态耦合,如图 4所示。

|

图 4 气候系统模式耦合示意 Fig. 4 Schematic of coupled climate system model |

为改善模式对中、低纬海洋模拟的效果,对CPL耦合器与MOM4海洋模式进行研究,重组MOM4并行架构、调整插值方案,解决MOM4模式与其他分量模式数据交换问题,实现MOM4海洋模式与BCC_CSM模式的耦合(Wei et al,2010)。伴随着大气化学、气溶胶等越来越多分量模式的加入,模式之间交互信息越来越多,越来越频繁,在未来工作中,需要对现有耦合技术进行优化与升级,提高耦合器对不同模式的支持适应能力,提高耦合计算效率,降低耦合复杂性,优化模式计算负载平衡(王兰宁等,2009)。

(2) 大规模异构高性能计算是未来大规模并行计算的重要发展方向,目前正在实施建立基于GPU和MIC众核芯片的异构高性能计算试验环境,以GRAPES天气模式(伍湘君等,2010)和BCC_AGCM气候模式(Wu et al,2010)为基础,开展气象数值模式众核加速技术研究,分析不同众核芯片对数值模式的适应性,提炼数值模式在众核芯片移植、优化的普适性规律,对未来异构众核计算系统的建立及数值模式异构协同算法进行技术探索。

(3) 基于主要业务用高性能计算系统,开展并行I/O技术的研究工作,对BCC_AGCM全球大气环流模式的软件设计框架、数据存储结构和I/O算法进行深入分析,在应用层实现模式计算结果文件并行输出功能,结果精确、合理,模式系统能够稳定运行。在未来工作中,将对此技术进行深入研究,实现支持多种数据格式的并行I/O算法(魏敏等,2014)。

2.3 软件及工具高性能计算环境已提供的主要软件及工具,如表 1所示,将根据应用需求,进一步丰富和完善。

|

|

表 1 气象高性能计算环境主要软件及工具 Table 1 Major software and tools of meteorological high performance computing environment |

将高性能计算技术与气象业务应用有效地融合起来,高性能计算技术作为气象业务应用的基础支撑,为其提供服务,同时,气象业务应用的发展对高性能计算技术不断提出新的需求,也促进其不断创新和发展。

依据气象数值模式业务的需求,提出了气象高性能计算应用服务环境解决方案,在新建设的高性能计算系统中进行了初步实施。未来将在信息系统设计、业务流程规划和软件应用框架构建等方面进行深入研究,借鉴国内外相关工作,扩大用户服务领域和范围,进一步优化建立数据驱动、集约高效的高性能计算应用服务环境。

高嵩, 代刊, 薛峰, 2014. 基于MICAPS3.2平台的格点编辑平台设计与开发[J]. 气象, 40(9): 1152-1158. |

胡江凯, 王雨, 王毅涛, 等, 2005. 国家气象中心T213L31数值预报运行监控方案及预报效果评估[J]. 应用气象学报, 16(2): 249-259. DOI:10.11898/1001-7313.20050231 |

嵇磊, 周珺, 李宏宇, 等, 2014. 基于BJ-RUC系统的人影冷云催化潜力识别模式平台设计[J]. 气象, 40(8): 981-991. |

李湘, 2010. 气象通信系统发展与展望[J]. 气象, 36(7): 56-61. DOI:10.7519/j.issn.1000-0526.2010.07.011 |

李志鹏, 张玮, 黄少平, 等, 2012. 自动气象站数据实时质量控制业务软件设计与实现[J]. 气象, 38(3): 371-376. DOI:10.11676/qxxb2012.033 |

梁海河, 孟昭林, 张春晖, 等, 2011. 综合气象观测运行监控系统[J]. 气象, 37(10): 1292-1300. DOI:10.7519/j.issn.1000-0526.2011.10.013 |

沈文海, 2012. 网格计算在气象高性能计算领域的应用前景探讨[J]. 气象科技进展, 2(1): 48-51. |

沈文海, 赵芳, 高华云, 等, 2004. 国家级气象资料存储检索系统的建立[J]. 应用气象学报, 15(6): 727-736. |

王彬, 肖文名, 李永生, 等, 2011. 华南区域中心计算资源管理系统的建立与应用[J]. 气象, 37(6): 764-770. DOI:10.7519/j.issn.1000-0526.2011.06.016 |

王彬, 宗翔, 田浩, 2010. 国家气象计算网格的设计与建立[J]. 应用气象学报, 21(5): 632-640. DOI:10.11898/1001-7313.20100514 |

王斌, 周天军, 俞永强, 等, 2008. 地球系统模式发展展望[J]. 气象学报, 66(6): 857-869. DOI:10.11676/qxxb2008.078 |

王兰宁, 李清泉, 吴统文, 等, 2009. 插值方案对耦合系统积分稳定性影响的数值研究[J]. 南京气象学院学报, 32(2): 230-238. |

王雨, 闫之辉, 2007. 降水检验方案变化对降水检验评估效果的影响分析[J]. 气象, 33(12): 53-61. DOI:10.7519/j.issn.1000-0526.2007.12.008 |

王在志, 吴国雄, 刘平, 等, 2005. 全球海—陆—气耦合模式大气模式分量的发展及其气候模拟性能Ⅰ——水平分辨率的影响[J]. 热带气象学报, 21(3): 225-237. |

魏敏, 罗勇, 王兰宁, 等, 2005. 海气耦合模式的优化方法研究[J]. 应用气象学报, 16(3): 408-412. DOI:10.11898/1001-7313.20050316 |

魏敏, 徐金秀, 王在志, 2014. 并行I/O技术在气候数值模式中的应用研究[J]. 计算机技术与发展, 24(12): 11-15. |

温华洋, 华连生, 金素文, 等, 2013. 基于空间一致性的双套站数据选取方法探索[J]. 气象, 39(8): 1069-1075. DOI:10.7519/j.issn.1000-0526.2013.08.014 |

吴林林, 刘黎平, 徐海军, 等, 2013. 基于MICAPS3核心的人影业务平台设计与开发[J]. 气象, 39(3): 383-388. DOI:10.7519/j.issn.1000-0526.2013.03.014 |

伍湘君, 陈德辉, 宋君强, 等, 2010. GRAPES全球格点模式的并行计算负载平衡策略[J]. 气象学报, 68(5): 591-597. DOI:10.11676/qxxb2010.058 |

薛纪善, 陈德辉, 沈学顺, 等, 2008. 数值预报系统GRAPES的科学设计与应用[M]. 北京: 科学出版社, 383.

|

杨学胜, 张卫民, 陈德辉, 2005. 网格计算及其在气象中的应用[J]. 气象, 31(2): 79-82. DOI:10.7519/j.issn.1000-0526.2005.02.019 |

赵立成, 王素娟, 施进明, 等, 2002. 国家卫星气象中心信息共享体制研究与技术实现[J]. 应用气象学报, 13(5): 627-632. |

郑永光, 林隐静, 朱文剑, 等, 2013. 强对流天气综合监测业务系统建设[J]. 气象, 39(2): 234-240. DOI:10.7519/j.issn.1000-0526.2013.02.013 |

中国气象局. 2012. 气象信息网络系统总体设计.

|

Wei Min, Wang Lanning, 2010. The Implementation of Coupling Algorithm for MOM4 and BCC_CSM Model[J]. International Conference on Information Science and Engineering. |

Wu Tongwen, Li Weiping, Ji Jinjun, et al, 2013. Global carbon budgets simulated by the Beijing Climate Center Climate System Model for the last century[J]. J Geophys Res, 118: 1-22. |

Wu Tongwen, Yu Rucong, Zhang Fang, 2010. The Beijing Climate Center atmospheric general circulation model: Ddescription and its performance for the present-day climate[J]. Clim Dyn, 34: 123-147. DOI:10.1007/s00382-008-0487-2 |

2015, Vol. 41

2015, Vol. 41