2. 先进信息网络北京实验室, 北京 100124;

3. 华云升达气象科技有限公司, 北京 102299

2. Beijing Laboratory of Advanced Information Network, Beijing 100124;

3. Huayun Shengda Meteorological Technology Co., Ltd., Beijing 102299

云作为降水的基础(王烁等,2021;程鹏等,2022),其形状及数量变化对天气预报有极其重要的指导作用(许健民,2021),所以准确观测云对降水预测(岳治国等,2021;桂海林等,2019;万夫敬和刁秀广,2018)、天气预报、军事和社会保障等方面具有重要意义。目前,云的观测方法有卫星遥感云观测和地基云观测,地基云观测由地面向天空集中观测局部区域内云的分布和变化情况,观测到的地基云图有较高的时空分辨率,刻画了云体形状、结构和纹理等方面较多的细节信息,为提升天气预报的准确性(智协飞等,2021;黄兴友等,2020;胡树贞等,2020)提供了帮助。

云状和云量是地基云观测中的两个基本要素,近几年,大部分地基云观测方法还是人工观测,由观测员根据自己的经验判断地基云图的云状和云量,但观测员易受主观意识和情绪干扰,使观测结果缺乏不确定性。为了解决上述问题,地基云图自动观测方法随之发展起来,而准确识别和分割地基云图是实现自动观测的关键点。目前,地基云图识别和分割技术取得了一定的研究进展。在地基云图识别方面,Zhang et al(2018)提出基于深度卷积神经网络的地基云分类网络(ground-based cloud classification with deep convolutional neural network, CloudNet),实现11类地基云图的分类,但分类准确率还有待提高;段向军和王敏(2020)利用迁移学习识别11类地基云图,通过试验发现地基云图识别效果不均衡;贾克斌等(2021)提出轻量化地基云分类网络(lightweight ground-based cloud image classification network, LCCNet),提高了11类地基云图的分类准确率,但存在地基云图混淆的情况。在地基云图分割技术方面,毋立芳等(2018)提出一种基于超像素分析的全卷积网络-卷积神经网络(fully convolutional networks-convolutional neural networks, FCN-CNN),将每个像素点的聚类输入FCN-CNN网络,实现准确的地基云图分割;沈慧想等(2019)提出一种对称式密集连接卷积神经网络模型,提高了地基云图分割精度,但模型参数量太大,容易发生过拟合;Dev et al(2019)提出一种昼夜云图分割网络(deep network for nychthemeron cloud image segmentation, CloudSegNet),准确分割地基云图,但用于模型研究的数据量少且没有考虑太阳光干扰,导致网络对晴空下地基云图分割效果不好。

虽然现有地基云图识别和分割技术已经取得不错效果,但这些技术或单独用于地基云图识别,或单独用于地基云图分割,对此本文提出一种地基云图识别与分割联合网络模型(joint network model of ground-based cloud image recognition and segmentation, GCRSegNet),该模型利用识别与分割两个任务之间特征的相关性,促进地基云图识别与分割泛化性能的提升,相比单任务学习,本文方法在一个网络中实现地基云图识别和分割两个任务,并获得了94.28%的识别准确率和93.85%的分割准确率。

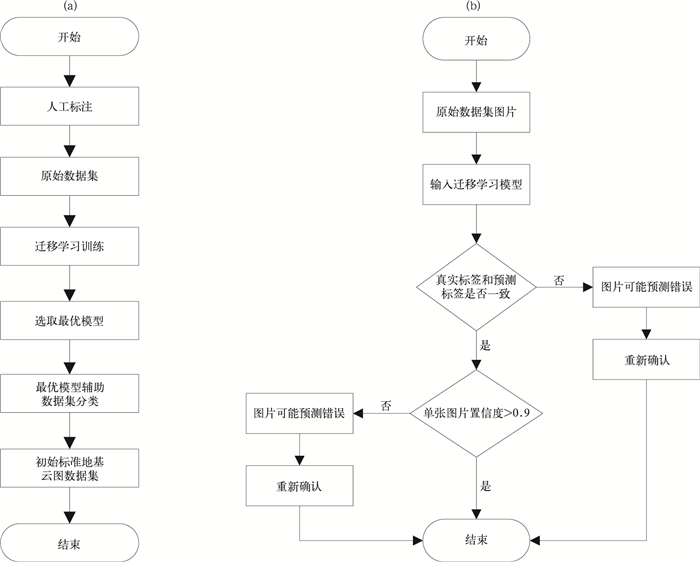

1 地基云图数据集GBCD和GBCD-GT 1.1 初始标准地基云图数据集构建本文数据来自全天空成像仪(total sky imager, TSI)每日在06—18时(北京时,下同)采集的包含一种云或大部分云体属于一种类别的地基云图,并利用Zhang(2000)相机标定法处理采集的地基云图,使其恢复正常的视觉感观。根据《地面气象观测规范》(中国气象局,2003),将预处理后的地基云图分为10种云类,为保证后续试验的完整性,增加一种无云天空作为第11类地基云图,分类流程如图 1所示。

|

图 1 初始标准地基云图数据集构建方法 (a)建立标签模型的流程,(b)标签模型的使用 Fig. 1 Construction method of initial standard ground cloud image dataset (a) process of establishing label model, (b) use of label model |

构建标准地基云图数据集的流程如图 1a所示。首先在专业气象观测人员的指导下人工标注地基云图,形成包含11类地基云图且具有一定专业性的原始数据集。为弥补人工标注中存在的错误分类,借助视觉几何组(visual geometry group network, VGG16)(Simonyan and Zisserman, 2014)、深度残差神经网络(deep residual network, ResNet-152) (He et al, 2016)、稠密卷积网络(dense convolutional network, DensNet-201)(Huang et al, 2017)和LCCNet网络作为迁移学习模型辅助地基云图分类,分别在不同解冻层数下的五种迁移学习模型中训练原始数据集,表 1展示了每个模型的最优准确率及其对应的解冻层数。对比表中结果发现,LCCNet在解冻2层时准确率优于其他模型;最后利用LCCNet辅助数据集二次分类,得到初始标准地基云图数据集。

|

|

表 1 原始数据集下模型最优迁移学习效果对比 Table 1 Comparison of model optimal transfer learning effect under original dataset |

利用LCCNet模型辅助分类的流程如图 1b所示,只需对比地基云图的实际标签与网络输出标签,当且仅当LCCNet预测图片的置信度大于0.9则认为图片分类正确,否则需要重新确认标签。在初始数据集上不断重复上述步骤,当且仅当被LCCNet分类正确的地基云图数量占总地基云图数量的95%以上,认为二次分类的地基云图数据具有专业参考性,进而形成初始标准地基云图数据集。

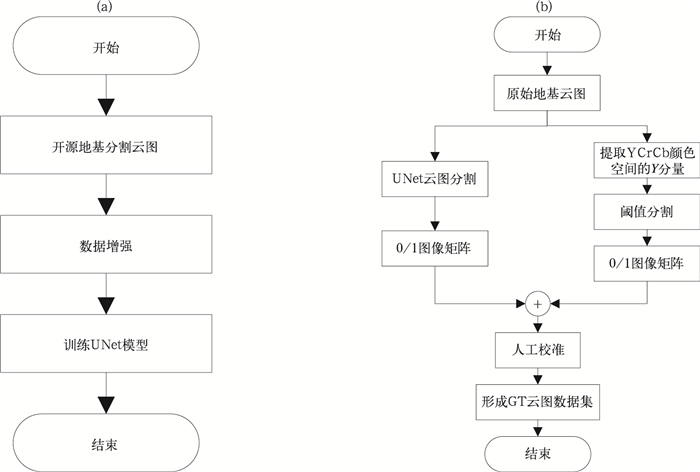

1.2 标准GT数据集构建基于原始标准地基云图数据集分割地基云图,并将分类标签一致的GT图归为同类,获得带分类标签的GT数据集,构建流程如图 2所示。

|

图 2 标准GT数据集构建方法 (a)预训练模型,(b)图像分割与太阳光去除 Fig. 2 Construction method of standard GT dataset (a) pre-training model, (b) image segmentation and sunlight removal |

为准确分割地基云图,需要预训练分割模型(Convolutional Networks for Biomedical Image Segmentation, UNet),流程如图 2a所示。将开源的地基云图分割数据集Singapore Whole sky IMaging SEGmentation Database(Dev et al, 2017a),Singapore Whole sky Nighttime Imaging SEGmentation Database(Dev et al, 2017b)中的数据,通过翻转和固定角度旋转扩增到6768张,并作为UNet网络的训练数据。

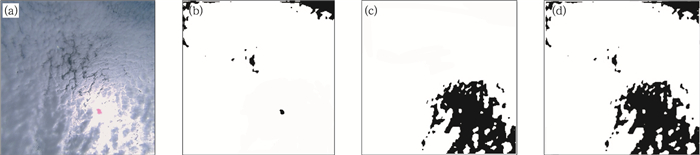

由于初始标准地基云图数据集中大量白天地基云图包含强烈太阳光,严重影响GT数据集构建。经对比分析,发现太阳光的亮度高于云体亮度,如图 3a所示,因此利用如图 2b所示的流程,构建正确的GT图。首先经过UNet网络获得地基云图的0/1图像矩阵,同时经过阈值分割地基云图,将大于阈值的部分判为太阳光,小于阈值的部分判为非太阳光,如图 3c所示;最后将图像矩阵和阈值分割结果相与,得到去除太阳光的分割图,效果如图 3d所示。为提高数据集置信度,人工逐张校准标注GT图,最后形成标准带标签的GT地基云图数据集。

|

图 3 GT数据集效果图 (a)原图,(b)UNet分割图,(c)太阳强光,(d)本文分割图 Fig. 3 Effect diagram of GT dataset (a) original image, (b) segmentation image of UNet, (c) the sun glare, (d) segmentation image of this paper |

为保证后续试验中充分的数据支撑,利用翻转和固定角度旋转对初始标准地基云图数据集和GT数据集进行数据增强,形成最终的地基云图数据集(GBCD)和GT数据集(GBCD-GT),数据构成如表 2所示。

|

|

表 2 数据集GBCD和GBCD-GT构成 Table 2 Composition of datasets GBCD and GBCD-GT |

多任务学习将多个相关任务放在一起学习并共享一个模型,在防止模型过拟合的同时,一定程度上减少了模型参数量;通过任务之间共享特征,相互助力,提升各项任务的效果;多个任务通过一次前向计算获取结果,提高多任务实现效率。

多任务学习模式的参数硬共享是指所有任务共享隐藏层参数,在一定程度上降低了模型过拟合的风险。故本文采用参数硬共享模式,将不同任务通过底层共享特征实现信息的相互补充,降低参数量,提升网络的泛化能力。

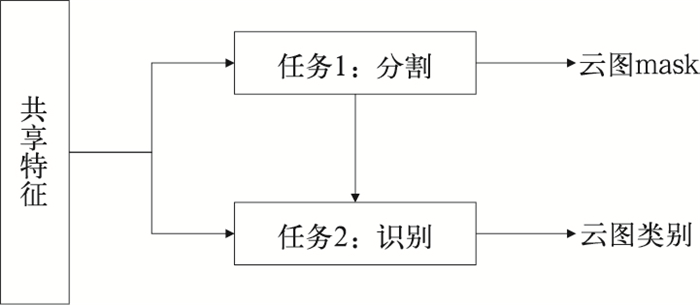

本文根据地基云图的形态特点,设计了基于多任务学习的地基云图识别和分割联合网络模型,结构如图 4所示。该模型首先通过CNN提取图像的共享特征,然后对共享特征进一步提取识别和分割两个任务的特定特征,最后识别网络结合共享特征和分割特征实现地基云图识别,以解决现有网络鲁棒性差的问题。

|

图 4 多任务学习模型构建原理 Fig. 4 Principle of multi-task learning model construction |

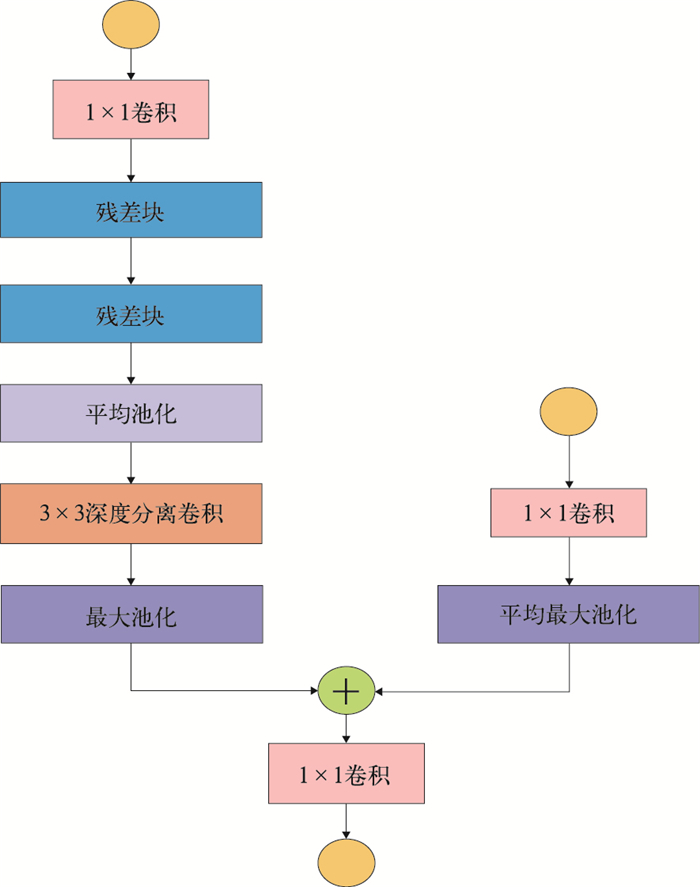

根据模型设计原理,本文网络模型分为三个部分,如图 5所示,图中不同的功能模块用不同的颜色表示。第一部分通过共享网络提取共享特征,在一定程度上降低网络过拟合的风险;第二部分通过分割网络学习不同尺度的共享特征,定位云体像素,输出地基云图掩膜mask;第三部分通过识别网络融合多尺度共享特征和分割网络提供的大尺度特征,提取特定的特征信息进行地基云图分类,输出地基云图类别。

|

图 5 GCRSegNet模型结构图 Fig. 5 GCRSegNet model structure diagram |

在网络优化学习过程中,整个网络的损失函数为两个任务损失函数之和,如式(1)所示:

| $ L=L_{\mathrm{cls}}+L_{\mathrm{seg}} $ | (1) |

式中: L为总损失函数,包括用交叉熵损失函数计算的识别网络损失Lcls和用对数似然损失函数计算的分割网络损失Lseg。

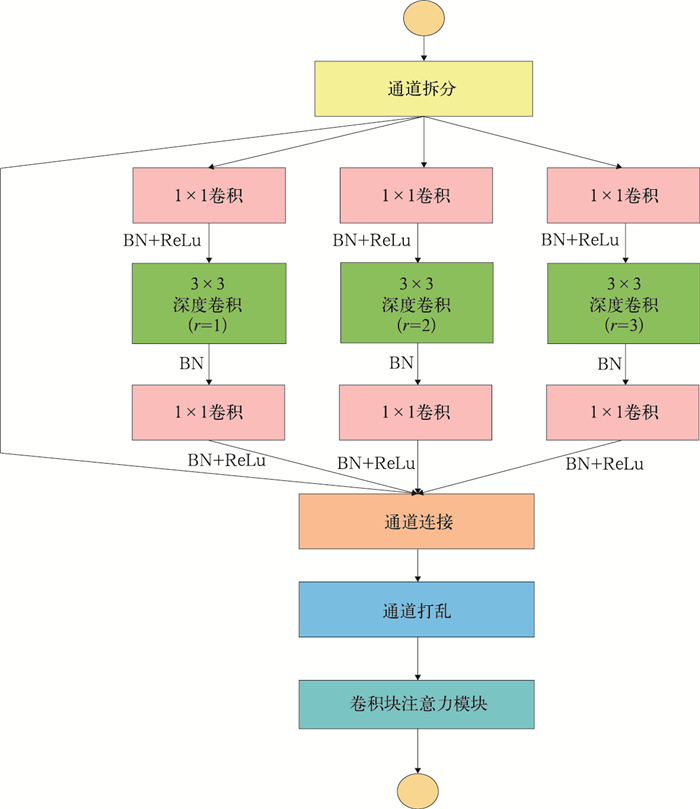

2.2.1 共享网络在共享网络中,首先利用普通卷积和池化提取图像浅层特征;然后利用4个stage模块提取图像深层特征,每个stage由不同数量的特征提取单元和一个下采样单元组成,特征提取单元如图 6所示,用卷积块注意力模块(convolutional block attention module, CBAM)作注意力模块,下采样单元设计借鉴LCCNet;最后经过1×1卷积,整合特征信息,获得共享特征。

|

图 6 stage中的特征提取单元 Fig. 6 Feature extraction unit in stage |

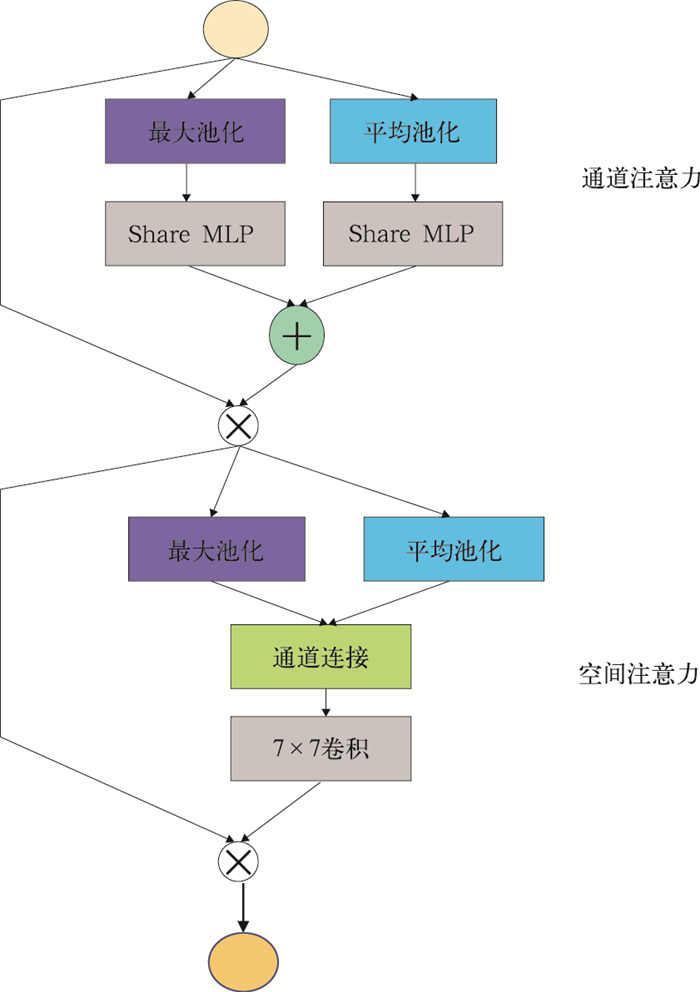

CBAM结构如图 7所示,由通道注意力和空间注意力串行连接组成,是一个轻量级模块,从通道和空间两方面提取更多地基云图细节和位置信息,便于后续特征学习。

|

图 7 注意力模块CBAM Fig. 7 Attention module CBAM |

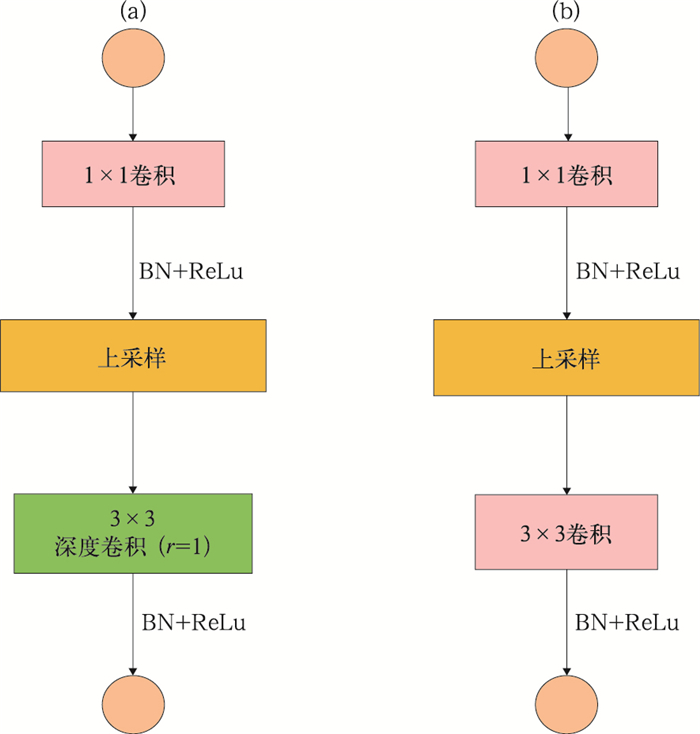

分割网络需要将共享特征经过上采样还原到原始图像尺寸,让特征以分割图形式重现,故分割网络的主要组成部分是上采样单元。为尽量减少模型参数量,上采样单元a使用一个膨胀率为1的深度卷积,结构如图 8a所示;相比上采样单元a,上采样单元b用普通卷积代替深度卷积,如图 8b所示。为弥补深度卷积带来的特征损失,采用concatenate通道聚合方法将共享网络与分割网络中具有相同尺度特征的通道进行合并,实现精细的图像特征重现。

|

图 8 上采样单元结构 (a)上采样单元a,(b)上采样单元b Fig. 8 Up-sampling unit structure (a) up-sampling unit a, (b) up-sampling unit b |

识别网络融合了共享特征和分割网络倒数第二层特征,结构如图 9所示。首先共享特征经过1×1卷积和池化,降低信息冗余,保留主要特征;接着分割网络倒数第二层特征经过残差块、平均池化和组卷积,既能缓解由网络过深引起网络性能下降的问题,提取高维特征信息,又能有效利用不同通道在相同空间位置上的特征信息,保留分割特征的全局信息;最后将上述两种特征融合,经过全连接层对特征进行分类,达到分类地基云图的目的。

|

图 9 特征融合模块结构 Fig. 9 Feature fusion module structure |

本节介绍试验配置,试验指标,试验结果及分析。

3.1 试验配置本文在GBCD和GBCD-GT数据集上进行试验,为了保证网络较好的特征学习能力,将两个数据集分别按8:1:1分成训练集、验证集和测试集,训练batch_size为32,epoch为100,初始学习率为0.001,优化器为Adam。

本文将准确率(Accuracy)、像素准确率(pixel accuracy, PA)、平均交并比(mean intersection over union, MIoU)作为试验评价指标,计算公式如下。

| $ \text { Accuracy }=\frac{\sum\limits_{i=1}^n \mathrm{TP}(i)}{\text { total }} $ | (2) |

| $ \mathrm{PA}=\frac{\mathrm{TP}+\mathrm{TN}}{\mathrm{FN}+\mathrm{FP}+\mathrm{TN}+\mathrm{TP}} $ | (3) |

| $ \mathrm{MIoU}=\frac{1}{n+1} \sum\limits_{i=1}^n \frac{\mathrm{TP}}{\mathrm{FN}+\mathrm{FP}+\mathrm{TP}} $ | (4) |

式(2)中,i=1, 2, 3, …, n(n=11),total为图片总数量;式(3)和式(4)中,TP为被模型分类正确的正样本,TN为被模型分类正确的负样本,FN为被模型分类错误的正样本,FP为被模型分类错误的负样本,n为类别数。

3.2 试验结果及分析 3.2.1 识别对比试验为了表明模型GCRSegNet能准确识别地基云图,将网络GCRSegNet与现有经典的单任务识别网络在准确率上进行对比,试验结果如表 3所示。

|

|

表 3 分类网络性能比较 Table 3 Performance comparison of classified networks |

表中试验结果表明,虽然单任务学习模型CloudNet和经典分类网络(inverted residuals and linear bottlenecks,MobileNet-V2)的准确率均在90%以上,LCCNet甚至达到了93.86%,但GCRSegNet准确率高达94.28%。由此证明该模型能在实现两个任务的前提下准确识别地基云图,为模型的实际应用提供了可能性。

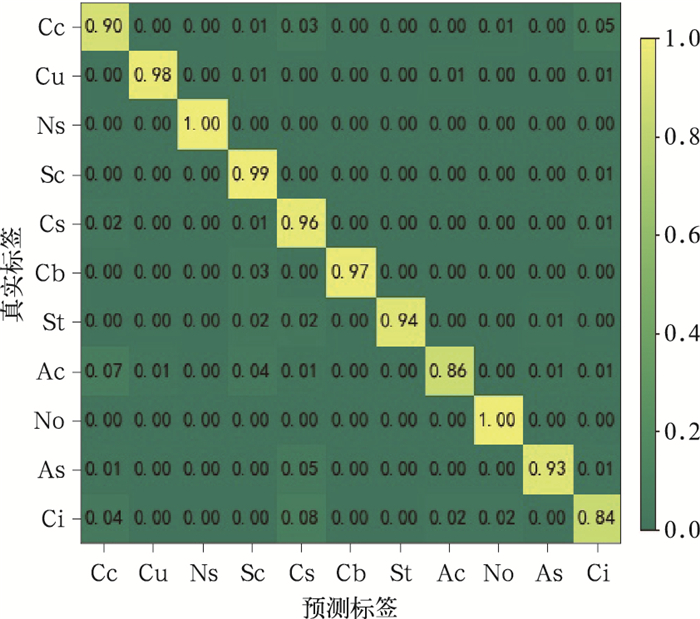

从混淆矩阵分析模型GCRSegNet在地基云图识别中的效果,如图 10所示。图中横轴为预测类别,纵轴为真实类别,横纵轴交点处的值为正确识别或错误识别率。图 10表明,在模型GCRSegNet中,大多类别云体的识别率在90%以上,只有Ac和Ci两种云的识别率在90%以下,因为在GCRSegNet中存在Ac与Cc和Sc、Ci与Cs和Cc混淆的情况。

|

图 10 模型GCRSegNet的混淆矩阵 Fig. 10 Confusion matrix of GCRSegNet model |

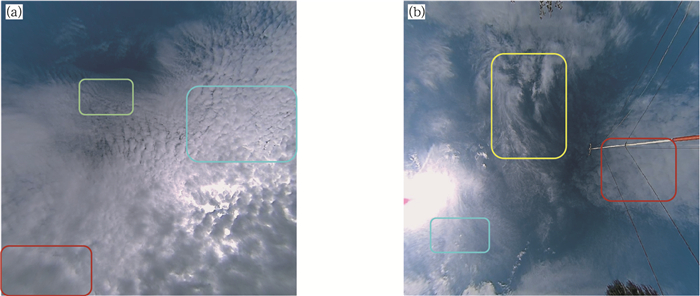

在实际地基云图中,Ac、Cc和Sc存在相互转换的关系,并在某些时刻Ac与Cc和Sc结构相似,容易产生混淆,如图 11a所示,红色框区域为Sc,蓝色框区域为Ac,黄色框区域为Cc,因此Ac易被预测为Cc和Sc;而Ci、Cs与Cc之间存在相互变换的关系,且变换频率较高,因此会导致一张地基云图包含两种或者三种云,如图 11b所示,红色框区域为Cc,蓝色框区域为Cs,黄色框区域为Ci,致使Ci可能被预测为Cc和Cs。

|

图 11 混淆地基云图 (a)Sc(红框)、Ac(蓝框)和Cc(黄框),(b)Cc(红框)、Cs(蓝框)和Ci(黄框) Fig. 11 Confusion ground-based cloud images (a) Sc (red frame), Ac (blue frame), and Cc (yellow frame), (b) Cc (red frame), Cs (blue frame), and Ci (yellow frame) |

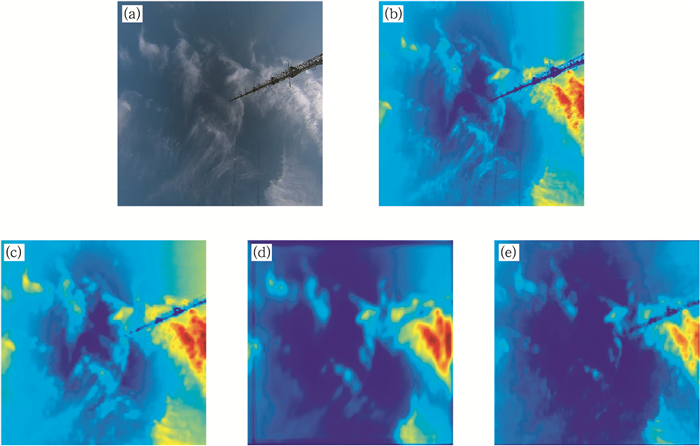

卷云Ci颜色较浅,不利于网络提取足够多的特征进行学习,且在分割网络中将特征复原到分割图的过程可能会丢掉部分细节特征,导致颜色较浅的卷云不易被分割出来,如图 12所示。比较共享网络和分割网络中尺度相同的特征图,如图 12b和12e,虽然具有相同尺度,但在图 12e中难以识别出颜色较浅的云体,同样在图 12c和12d中也存在分割网络难以把颜色浅的云体表示出来,如图 12d所示。因此,颜色较浅的卷云分割特征会影响其在识别网络中起到的作用,进而影响卷云识别准确率。

|

图 12 特征图展示 (a)原图,(b)卷积特征图256×256,(c)最大池化特征图128×128,(d)上采样单元a特征图128×128,(e)上采样单元b特征图256×256 Fig. 12 Feature map display (a) original image, (b) feature map of convolution of 256×256, (c) feature map of max pooling of 128×128, (d) feature map of up-sampling Unit a of 128×128, (e) feature map of up-sampling Unit b of 256×256 |

因此,还需进一步优化GCRSegNet模型,以提高对较浅云体的识别效果,并进一步研究能同时识别与分割多种地基云图的多任务模型,减小不同地基云图之间的相互影响。

3.2.2 分割对比试验将网络GCRSegNet与现有经典的语义分割网络在像素准确率PA和平均交并比MIoU上进行对比,试验结果如表 4所示。

|

|

表 4 分割网络性能对比 Table 4 Performance comparison of segmentation networks |

从表中试验结果表明,分割网络(deep convolutional encoder-decoder architecture for image segmentation, SegNet)、UNet、深度非对称实时分割网络(depth-wise asymmetric bottleneck for real-time semantic segmentation, DABNet)和CloudSegNet的PA均达到90%以上,其中CloudSegNet网络的PA达到91.97%,MIoU达到69.11%,但GCRSegNet的PA达到93.85%,比CloudSegNet高了近1.88%,MIoU达到71.58%。从以上的对比试验证明,网络GCRSegNet在实现多任务的同时,能准确分割地基云图。

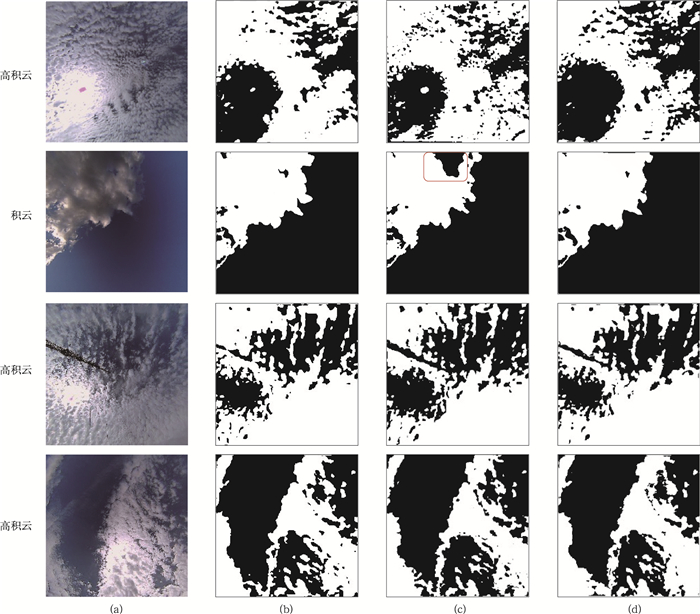

将网络UNet和GCRSegNet的试验效果进行可视化,如图 13所示。从对比结果中发现,GCRSegNet和UNet均难以辨认丝缕状云体,但对于地基云图边缘颜色较深的云体,GCRSegNet分割精度高于UNet,如图中红色框所示,进一步证明了GCRSegNet网络能准确分割出颜色结构不一样的地基云图。

|

图 13 地基云图分割结果 (a)原图,(b)真值图,(c)UNet输出,(d)GCRSegNet输出 Fig. 13 Segmentation results of ground-based cloud image (a) original image, (b) GroundTruth, (c) output of UNet, (d) output of GCRSegNet |

为了证明地基云图识别和分割联合检测的有效性,把在模型GCRSegNet识别网络中没有融合分割特征,同时实现识别和分割两个任务的模型命名为GCRSegNet*。并将两模型GCRSegNet*和GCRSegNet在Accuracy、PA和MIoU上进行对比,试验结果如表 5所示。

|

|

表 5 多任务模型性能对比 Table 5 Comparison of multitasking model performance |

从表中试验结果发现,GCRSegNet*没有在识别任务中加入分割特征,试验结果Accuracy、PA和MIoU分别低于GCRSegNet近10%、12%和5%,证明GCRSegNet模型对地基云图有较好的特征表达能力,为地基云图识别和分割联合的实际应用提供了一种可行方案。

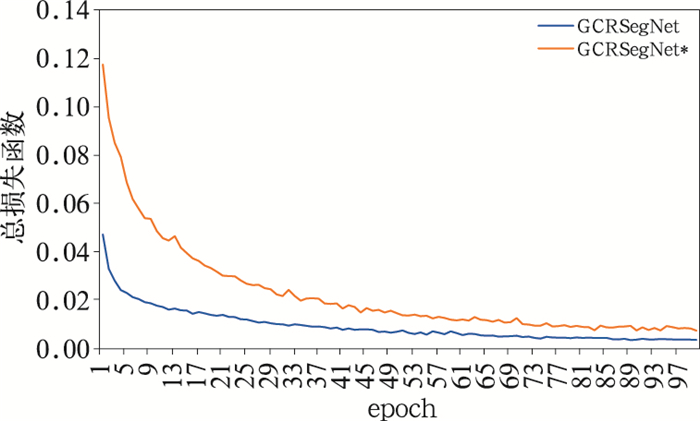

从损失函数收敛情况来衡量GCRSegNet*和GCRSegNet模型性能,如图 14所示。从图中发现GCRSegNet模型的总损失函数收敛更快,进一步证明GCRSegNet模型泛化性和鲁棒性较好,能准确识别和分割地基云图。

|

图 14 GCRSegNet*和GCRSegNet网络总损失函数对比 Fig. 14 Comparison of network Loss between GCRSegNet* and GCRSegNet |

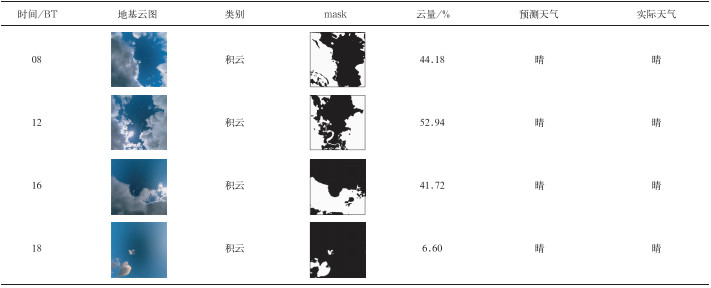

鉴于模型GCRSegNet最后输出地基云图类别和分割图,故利用模型GCRSegNet可以预测地基云图云状和云量,并根据云状和云量预测天气变化,实现自动地基云观测。将在2018年9月6日08、12、16、18时拍摄的地基云图经过预处理后,利用GCRSegNet模型的输出结果判断云状和云量,结果如表 6所示。根据模型输出类别为积云,且只有一个时间段的云量超过50%,其他时间段均在50%以下,预测可能属于晴天的天气状况,并与当时真实天气预报对比,证明模型GCRSegNet对天气状况识别有一定的辅助作用。

|

|

表 6 模型预测天气结果: 2018年9月6日 Table 6 Model forecast weather results: 6 September 2018 |

(1) 通过人工标注、迁移学习和数据增强,将TSI采集的地基云图分成包含11类地基云图的GBCD数据集,共12 006张;借助网络分割、去除太阳光和人工校准,将GBCD中地基云图分割成对应GT图,最后形成带标签的GBCD-GT数据集,为后续建模研究奠定了基础。

(2) 基于多任务学习,构建了地基云图识别和分割联合网络模型GCRSegNet,并将该模型在准确率Accuracy、像素准确率PA和平均交并比MIoU上与单任务模型进行对比,发现GCRSegNet模型Accuracy达到94.28%,PA达到93.85%,MIoU达到71.58%,分别比最优的单任务模型提升了0.42%、1.75%、0.78%。为了证明地基云图识别与分割联合检测的有效性,本文将模型GCRSegNet*和GCRSegNet在Accuracy、PA和MIoU上进行对比,发现地基云图识别和分割联合检测的效果明显优于没有联合检测的效果。经过对比试验表明,GCRSegNet是所有对比模型中效果最好的,证明了GCRSegNet可以在多任务联合检测的前提下实现准确的地基云图识别与分割,为后续天气预报领域的研究提供了一种可行方案。

虽然本文实现了地基云图识别与分割联合检测,但后续可以进一步研究一张地基云图存在多种云的情况,并利用语义分割方法优化模型,提高两个任务的性能,达到准确识别和分割地基云图的目的。

程鹏, 罗汉, 甘泽文, 等, 2022. 大型无人机一次人工增雨试飞及催化响应分析[J]. 气象, 48(8): 1053-1061. Cheng P, Luo H, Gan Z W, et al, 2022. A large UAV artificial precipitation enhancement experiment and physical response analysis of the cloud seeding processes[J]. Meteor Mon, 48(8): 1053-1061 (in Chinese).

|

段向军, 王敏, 2020. 迁移深度学习地基云图自动识别的网络微调学习过程[J]. 电子器件, 43(6): 1257-1261. Duan X J, Wang M, 2020. An ground cloud image recognition method using AlexNet convolution neural network[J]. Chin J Electron Dev, 43(6): 1257-1261 (in Chinese). DOI:10.3969/j.issn.1005-9490.2020.06.012

|

桂海林, 诸葛小勇, 韦晓澄, 等, 2019. 基于Himawari-8卫星的云参数和降水关系研究[J]. 气象, 45(11): 1579-1588. Gui H L, Zhuge X Y, Wei X C, et al, 2019. Study on the relationship between Himawari-8-based cloud parameters and precipitation[J]. Meteor Mon, 45(11): 1579-1588 (in Chinese). DOI:10.7519/j.issn.1000-0526.2019.11.008

|

胡树贞, 曹晓钟, 陶法, 等, 2020. 船载毫米波云雷达观测西太平洋云宏观特征对比分析[J]. 气象, 46(6): 745-752. Hu S Z, Cao X Z, Tao F, et al, 2020. Comparative analysis of cloud macro characteristics from two shipborned millimeter wave cloud radars in the West Pacific[J]. Meteor Mon, 46(6): 745-752 (in Chinese).

|

黄兴友, 陆琳, 洪滔, 等, 2020. 利用毫米波云雷达数据反演层云微物理参数和云内湍流耗散率[J]. 大气科学学报, 43(5): 908-916. Huang X Y, Lu L, Hong T, et al, 2020. A case study on the retrieval of microphysical parameters and in-cloud stratus turbulent dissipation rate by millimeter-wave cloud radar measurement[J]. Trans Atmos Sci, 43(5): 908-916 (in Chinese).

|

贾克斌, 张亮, 刘鹏宇, 等, 2021. 基于轻量级神经网络的地基云图识别[J]. 北京工业大学学报, 47(5): 489-499. Jia K B, Zhang L, Liu P Y, et al, 2021. Ground-based cloud recognition based on lightweight neural network[J]. J Beijing Univ Technol, 47(5): 489-499 (in Chinese).

|

沈慧想, 夏旻, 施必成, 等, 2019. 对称式密集连接网络的地基云图分割方法[J]. 计算机工程与应用, 55(17): 207-213. Shen H X, Xia M, Shi B C, et al, 2019. Ground-based cloud image segmentation method based on symmetric convolutional neural network with dense connection[J]. Comput Eng Appl, 55(17): 207-213 (in Chinese). DOI:10.3778/j.issn.1002-8331.1902-0034

|

万夫敬, 刁秀广, 2018. 两次MCC红外云图特征与天气实况异同性分析[J]. 气象, 44(6): 759-770. Wan F J, Diao X G, 2018. Comparative analysis on cloud evolution features and weather of two MCCs[J]. Meteor Mon, 44(6): 759-770 (in Chinese).

|

王烁, 张佃国, 王文青, 等, 2021. 初冬一次层状云较弱云区垂直结构的飞机观测[J]. 应用气象学报, 32(6): 677-690. Wang S, Zhang D G, Wang W Q, et al, 2021. Aircraft measurement of the vertical structure of a weak stratiform cloud in early winter[J]. J Appl Meteor Sci, 32(6): 677-690 (in Chinese).

|

毋立芳, 贺娇瑜, 简萌, 等, 2018. 局部聚类分析的FCN-CNN云图分割方法[J]. 软件学报, 29(4): 1049-1059. Wu L F, He J Y, Jian M, et al, 2018. Local clustering analysis based FCN-CNN for cloud image segmentation[J]. J Softw, 29(4): 1049-1059 (in Chinese).

|

许健民, 2021. 用对流-辐射平衡理论理解对流云的外观表现[J]. 气象, 47(1): 1-10. Xu J M, 2021. Appearance of convective clouds explained by radiative-convective equilibrium[J]. Meteor Mon, 47(1): 1-10 (in Chinese).

|

岳治国, 余兴, 刘贵华, 等, 2021. 一次飞机冷云增雨作业效果检验[J]. 气象学报, 79(5): 853-863. Yue Z G, Yu X, Liu G H, et al, 2021. Effect evaluation of an operational precipitation enhancement in cold clouds by aircraft[J]. Acta Meteor Sin, 79(5): 853-863 (in Chinese).

|

智协飞, 张珂珺, 田烨, 等, 2021. 基于神经网络和地理信息的华东及华南地区降水概率预报[J]. 大气科学学报, 44(3): 381-393. Zhi X F, Zhang K J, Tian Y, et al, 2021. Probabilistic precipitation forecast in East and South China based on neural network and geographic information[J]. Trans Atmos Sci, 44(3): 381-393 (in Chinese).

|

中国气象局, 2003. 地面气象观测规范[M]. 北京: 气象出版社. China Meteorological Administration, 2003. Standard of Surface Meteorological Observation[M].

Beijing: China Meteorological Press (in Chinese).

|

Badrinarayanan V, Kendall A, Cipolla R, 2017. SegNet: A deep convolutional encoder-decoder architecture for image segmentation[J]. IEEE Trans Pattern Anal Mach Intell, 39(12): 2481-2495.

|

Dev S, Lee Y H, Winkler S, 2017a. Color-based segmentation of sky/cloud images from ground-based cameras[J]. IEEE J-STARS, 10(1): 231-242.

|

Dev S, Savoy F M, Lee Y H, et al, 2017b. Nighttime sky/cloud image segmentation[C]//2017 IEEE International Conference on Image Processing (ICIP). Beijing: IEEE: 345-349.

|

Dev S, Nautiyal A, Lee Y H, et al, 2019. CloudSegNet: a deep network for nychthemeron cloud image segmentation[J]. IEEE Geosci Remote Sens Lett, 16(12): 1814-1818.

|

He K M, Zhang X Y, Ren S Q, et al, 2016. Deep residual learning for image recognition[C]//2016 IEEE Conference on Computer Vision and Pattern Recognition (CVPR). Las Vegas: IEEE: 770-778.

|

Huang G, Liu Z, van der Maaten L, et al, 2017. Densely connected convolutional networks[C]//2017 IEEE Conference on Computer Vision and Pattern Recognition (CVPR). Honolulu: IEEE: 4700-4708.

|

Li G, Yun I, Kim J, et al, 2019. DABNet: depth-wise asymmetric bottleneck for real-time semantic segmentation[C]//Proc. Brit. Mach. Vis. Conf. : 1-12.

|

Ronneberger O, Fischer P, Brox T, 2015. U-Net: convolutional networks for biomedical image segmentation[C]//18th International Conference on Medical Image Computing and Computer-Assisted Intervention. Munich: Springer: 234-241.

|

Sandler M, Howard A, Zhu M L, et al, 2018. MobileNetV2: inverted residuals and linear bottlenecks[C]//2018 IEEE/CVF Conference on Computer Vision and Pattern Recognition. Salt Lake City: IEEE: 4510-4520.

|

Simonyan K, Zisserman A, 2014. Very deep convolutional networks for large-scale image recognition[C]//Int. Conf. Learn. Represent., ICLR- Conf. Track Proc. : 1-14.

|

Szegedy C, Vanhoucke V, Ioffe S, et al, 2016. Rethinking the inception architecture for computer vision[C]//2016 IEEE Conference on Computer Vision and Pattern Recognition (CVPR). Las Vegas: IEEE: 2818-2826.

|

Zhang J L, Liu P, Zhang F, et al, 2018. CloudNet: ground-based cloud classification with deep convolutional neural network[J]. Geophys Res Lett, 45(16): 8665-8672.

|

Zhang Z Y, 2000. A flexible new technique for camera calibration[C]//2000 IEEE Transcations on Pattern Analysis & Machine Intelligence. Redmond: IEEE: 1330-1334.

|

2023, Vol. 49

2023, Vol. 49